Rafael Caro Fernández

Ingeniero de Software - Full Stack Developer - Plain Concepts

Introducción

En los últimos años, la inteligencia artificial ha dado un salto enorme en cuanto a su alcance y aplicaciones. Desde la irrupción de ChatGPT, que se ha vuelto imprescindible en muchos trabajos y en vida cotidiana, la IA nos ha permitido primero generar texto, luego crear imágenes y más recientemente producir videos con una calidad visual asombrosa.

Ahora, el salto va aún más allá: en los últimos meses hemos pasado de generar videos a construir mundos enteros a los que se puede entrar, explorar e incluso interactuar en tiempo real. Ya no hablamos únicamente de imágenes en movimiento, sino de universos sintéticos generados al instante a partir de un prompt de texto o de una simple imagen. Estos avances marcan el inicio de una nueva era donde la IA no solo describe o representa, sino que actúa como un motor de mundo, capaz de sostener física, memoria y narrativa durante la experiencia. De los ejemplos más significativos de este nuevo paradigma destacan Genie 3, desarrollado por Google DeepMind, y Mirage 2, de Dynamics Labs. Ambos sistemas son capaces de generar mundos interactivos que el usuario puede recorrer como si de un videojuego se tratase o modificar a su antojo mediante el uso de imágenes o textos. Todo esto sin el uso por debajo de ningún motor de videojuegos, estructura ni código, sino directamente mediante el uso de redes neuronales que predicen cada pixel en reacción de los inputs del usuario y al histórico del mismo.

Hace unas semanas, Google sorprendía con este modelo de mundo capaz de generar una enorme diversidad de entornos interactivos. Según su web, basta con un prompt para que Genie 3 construya entornos dinámicos que se pueden explorar en tiempo real, generando experiencias coherentes durante varios minutos, a 24 frames por segundo y con una resolución de 720p.

Uno de los aspectos más impresionantes de este modelo es su capacidad para mantener la consistencia a lo largo del tiempo; es decir, su “memoria”. Las acciones que realiza el usuario y que afectan al mundo se conservan durante toda la experiencia, como puede verse en los videos publicados por Google, donde por ejemplo una pintura permanece en la pared a lo largo de la interacción:

Video de Genie 3: Manteniendo la pintura en la pared (web original)

Al tratarse de una tecnología emergente, Genie 3 aún tiene limitaciones. El abanico de acciones que el usuario puede ejecutar es reducido, no logra simular con precisión localizaciones reales, la representación de textos dentro del mundo es limitada y la duración de la interacción se restringe a unos pocos minutos.

Actualmente, este modelo no está disponible para prueba directa, sino únicamente a través de videos proporcionados por DeepMind. Sin embargo, ya empiezan a aparecer otros sistemas que sí pueden probarse, como veremos en el siguiente caso.

A diferencia de Genie 3, Mirage 2, desarrollado por Dynamics Labs, genera sus mundos interactivos a partir de imágenes existentes. Basta con subir una imagen y un prompt de texto (que incluso puede ser autogenerado) para que el modelo transforme esos elementos en un escenario explorable, permitiendo recorrer y experimentar el entorno como si estuviéramos inmersos dentro de un videojuego.

Este modelo sí se puede probar a partir de su página web: https://demo.dynamicslab.ai/chaos

Las pruebas de un minuto funcionan bastante bien: se puede mover, saltar y añadir eventos mediante prompt, ofreciendo una experiencia interactiva inmediata.

Según la web de Dynamics Labs, Mirage 2 promete interacciones de más de 10 minutos con una latencia de 200 ms, y lo más sorprendente: podría ejecutarse en una GPU de consumo doméstico, lo que lo hace accesible para usuarios comunes.

Podemos encarnar a la infanta Margarita, aunque se pierde estabilidad visual al comenzar la experiencia

Entre sus limitaciones, se encuentra que los movimientos no siempre coinciden con lo solicitado, a veces se producen acciones involuntarias, y la estabilidad visual es limitada, ya que la “memoria” del mundo no se mantiene tanto a lo largo del tiempo.

Estos últimos modelos como Genie 3 y Mirage 2 han supuesto un gran salto en calidad, pero no surgieron de la nada. Para entender su relevancia es útil mirar atrás y ver cómo ha evolucionado la simulación de mundos. Primero, con los motores de videojuegos tradicionales como Unity u orientados a industria como Evergine, donde se simulaban las físicas y donde cada objeto, entorno y acción se programa de forma manual. Y más tarde, con los primeros intentos de aplicar IA generativa buscando automatizar parte del proceso.

En 2018, World Models de David Ha y Jürgen Schmidhuber introdujeron una idea clave: entrenar agentes de IA en entornos generados por redes neuronales en lugar de hacerlo en entornos reales o simulaciones tradicionales. Esto permitió que los agentes pudieran aprender más rápido, entrenando directamente dentro de un modelo interno del mundo. En la práctica, el agente ya no necesitaba interactuar con un sistema externo, sino que podía entrenarse dentro de su propia “imaginación”, prediciendo lo que ocurriría en los siguientes frames y actuando en consecuencia.

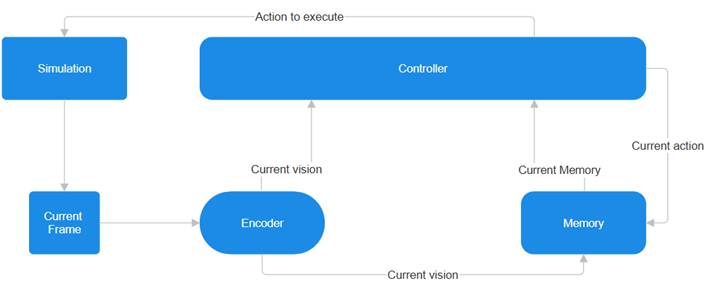

En el entrenamiento de una IA “normal”, la IA realiza acciones sobre una simulación (podríamos pensar que está actuando sobre un sistema, que podría ser un videojuego o cualquier tipo de software que admita inputs) intentando preveer en base a su memoria qué es lo que ocurrirá en los siguientes frames y actuando en consecuencia:

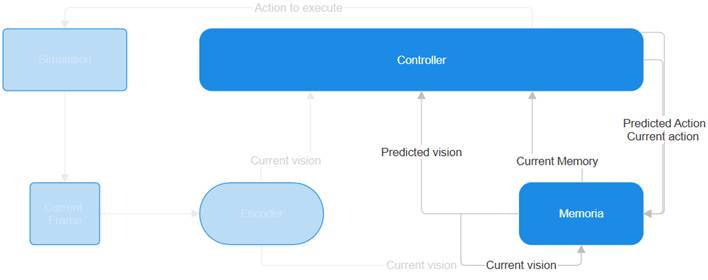

Con la idea de la simulación de mundo, el agente no tendría que estar conectado a un verdadero sistema sobre el que realizar las acciones, sino que directamente las acciones se realizarían sobre la propia memoria del agente, el cual “imagina” cual será la siguiente acción que ocurriría en el mundo.

Este concepto sirvió de base para que los nuevos modelos de mundo pudieran mantener cierta coherencia temporal y memoria, aunque todavía de forma limitada. En paralelo, surgieron los modelos de generación de video, como Sora de OpenAI o Kling de Kuaishou, que ampliaron la duración, la resolución y la complejidad de las escenas generadas.

Estos modelos, entrenados con cantidades masivas de videos, mostraron capacidades emergentes sorprendentes: lograron simular de manera plausible aspectos de personas, animales y entornos del mundo físico. Lo más llamativo es que estas propiedades no fueron programadas explícitamente mediante modelos 3D u objetos definidos, sino que surgieron directamente del entrenamiento a gran escala. Este hallazgo abrió un camino prometedor hacia la creación de simuladores digitales y físicos más realistas.

No obstante, todavía presentan limitaciones importantes. Les cuesta mantener las leyes físicas en interacciones básicas (por ejemplo, la rotura de un cristal o la transformación de un objeto al ser comido) y no siempre representan de forma consistente las consecuencias de las acciones. Aun así, estos avances son una clara señal de hacia dónde puede dirigirse el futuro de la simulación de mundos.

La siguiente iteración fue el entrenamiento de IAs generativas con videos de videojuegos, incorporando además el input del usuario como parte del entrenamiento. De esta manera, la IA aprendía de forma emergente qué significaba cada acción (saltar, atacar, moverse…) y, durante la simulación del mundo, podía alterar los siguientes frames en función de lo que quisiera hacer el jugador.

Con este enfoque surgió GameNGen, de OpenAI, considerado el primer motor de videojuegos que funciona únicamente con redes neuronales en entornos complejos. En sus demostraciones se muestra cómo es posible jugar al clásico DOOM a 20 frames por segundo en una TPU:

Siguiendo esa misma línea apareció Oasis, desarrollado por Decart. Este modelo de mundo para Minecraft es capaz de simular en tiempo real las físicas, reglas y gráficos del videojuego a partir de una sola imagen. Incluso cuentan con una demo jugable que permite experimentar con una simulación de Minecraft durante unos minutos:

Simulación de Minecraft en tiempo real

También han surgido avances en el uso de estos simuladores de mundo para el entrenamiento de agentes, como es el caso de GAIA-1, de Wayve. Se trata de una primera prueba de concepto capaz de generar un modelo de mundo orientado a la conducción autónoma, que permite a los sistemas anticipar y planear acciones, identificando peligros potenciales y explorando distintas posibilidades futuras. La incorporación de estos modelos de mundo en la conducción tiene el potencial de ayudar a los sistemas autónomos a entender mejor las decisiones humanas y a tomar decisiones más seguras y eficientes en situaciones del mundo real.

En conjunto, estos avances muestran cómo la simulación con IA ha ido evolucionando desde los primeros conceptos y experimentos hasta los primeros motores de videojuegos neuronales capaces de aprender directamente a partir de gameplays. Lo que empezó como simples entornos limitados o recreaciones de títulos concretos se está expandiendo ahora hacia motores de mundo más generalistas, como Genie 3 o Mirage 2. Estos ya no dependen de un videojuego preexistente ni de un conjunto cerrado de reglas, sino que generan universos dinámicos a partir de texto o imágenes, abriendo la puerta a una nueva etapa en la que la inteligencia artificial no solo reproduce mundos, sino que los crea y sostiene en tiempo real.

Estos motores de mundo abren un horizonte muy amplio. Si hoy, que apenas están empezando a dar sus primeros pasos, ya sorprenden con la fidelidad que demuestran, en los próximos años veremos cómo se convierten en herramientas capaces de transformar la forma de trabajar en distintos ámbitos.

Por un lado, Mirage 2 apunta al futuro del entretenimiento. Imaginemos videojuegos donde el escenario no está predefinido, sino que se genera en tiempo real en función de las decisiones del jugador. Mundos creados y compartidos al instante con amigos, narrativas que emergen de las propias acciones y partidas únicas e irrepetibles, como si cada experiencia fuera una historia personal.

Por otro lado, Genie 3 plantea una vía más enfocada al entrenamiento de agentes IA. Con él, sería posible entrenar robots a partir de modelos del mundo real, acelerando sus capacidades de aprendizaje. A partir de las imágenes captadas por sus cámaras y de simples prompts de texto, podrían ejecutar acciones sin necesidad de programación explícita. Genie 3 proporcionaría un espacio donde estos agentes —robots y sistemas autónomos— puedan entrenar, evaluar su rendimiento y descubrir sus limitaciones. Esta capacidad de “imaginar” y aprender en mundos virtuales podría ser uno de los catalizadores hacia la próxima gran etapa de la inteligencia artificial.

En última instancia, estos avances nos acercan a IAs que aprenden como los humanos: construyendo un modelo interno del mundo a partir de percepciones limitadas y tomando decisiones en función de él. Tal y como describió en 1971 Jay Wright Forrester, padre de la dinámica de sistemas:

“La imagen del mundo alrededor de nosotros, que llevamos en nuestra cabeza, es solo un modelo. Nadie en su cabeza se imagina a todo el mundo, gobiernos o países. Ha seleccionado conceptos y relaciones entre ellos, y los utiliza para representar el sistema real.”

Hoy, con herramientas como Genie 3 y Mirage 2, esas imágenes del mundo comienzan a materializarse en universos virtuales que podemos explorar, modificar y aprender, dando un primer paso hacia un futuro donde la inteligencia artificial imaginará, creará y coexistirá con nosotros en mundos dinámicos.

Rafael Caro Fernández

Ingeniero de Software - Full Stack Developer - Plain Concepts